FB 的盛衰史,成也「点赞」、败也「点赞」

「点赞」的偶然发明

2005 年,创业者 Rob Manuel 遇到了一个难题。

四年前的互联网泡沫之后,他跟两个朋友 Denise Wilton 和 Cal Henderson 一起创立了B3ta网站。像众多的新兴网站一样,他们也想尝试建立一个与众不同的有趣网站。

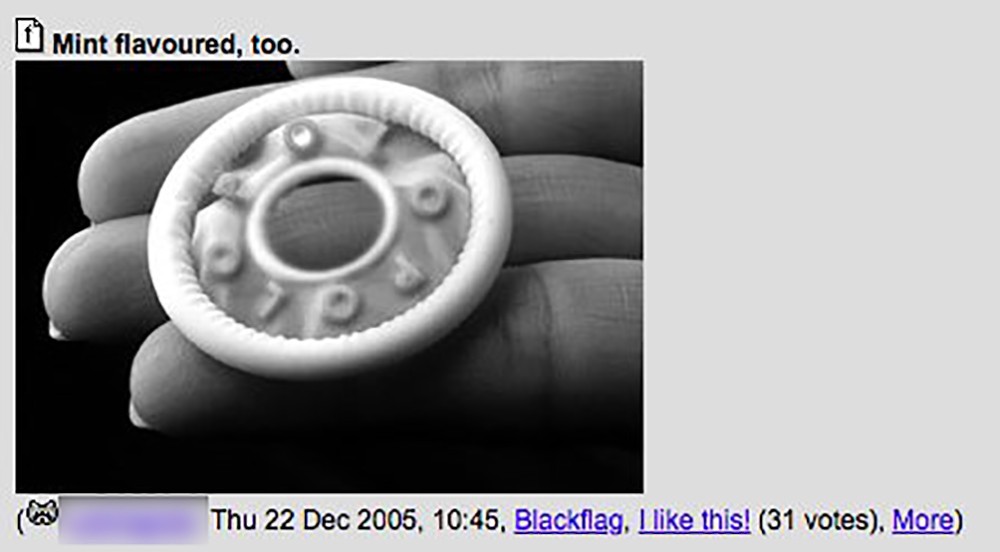

从产品本质上来说,B3ta 是一个 newsletter 和短讯分享平台,基于这两个上世纪 90 年代互联网早期的技术,网站内容以笑料为主。每周都会有包含了混搭、成熟和美学的图片比拼。但很快,这里就变成了一个分享创造性内容,涉及各个方面的社区,从简单的图片拼贴,到高超的动画剪辑,或者是各种艺术形式的天堂。

到 2005 年,B3ta 社区规模已经相当大,简单的平台式页面难以承载,Manuel 需要一种能准确找到好内容的方法。

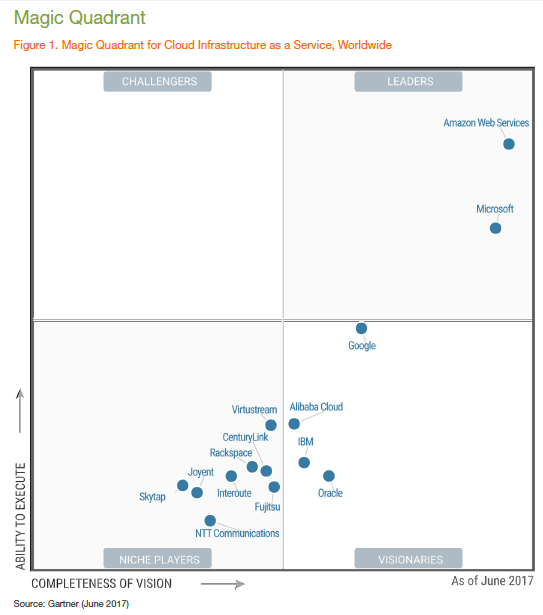

事实上,这是 2000 年初各个网络社区都在尝试解决的问题。2000 年上线的神秘的 FilePile 社区,运用了「+」「-」排名的方式,用户可以把内容顶上去或者拉下来。这对 B3ta 社区有深远影响。2004 年 12 月上线的 Digg.com 用一个简单的「Digg」按钮对链接进行排名。但早在这两个网站出现之前,像 Hot or Not 这样的网站( 扎克伯格在创立 Facebook 之前曾参考这个网站做了 FaceMash )开始用按钮测试用户的喜好。此时 Manuel 还在手动管理他的社区,并把这种投票按钮看作一种可能的解决方案:

我需要一个机制来处理大量的图片和文字内容。一个一个去读去看真的太累了,要为首页和邮件推送找到最好的内容,必须给用户一个简单明了的投票机制。我想采取用户和管理员筛选相结合的方式,由用户选出好的内容,再由管理员最终决定。

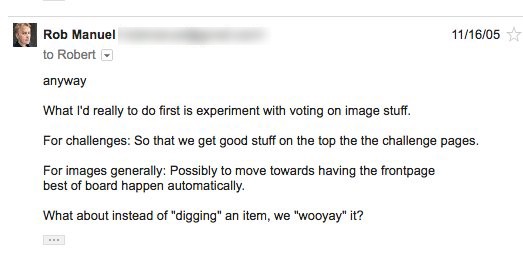

*上图是 Rob Manuel 2005 年 11 月写给 B3ta 开发者的邮件,*

*上图是 Rob Manuel 2005 年 11 月写给 B3ta 开发者的邮件,*

Manuel 随即写邮件给他的开发者,建议加上一个「wooyay」的按钮,虽然不清楚为什么最后变成了「like」,总之 2005 年 11 月,B3ta 社区增加了一个「喜欢」的按钮。

「点赞」机制的助推器:社交图谱和 News Feed

我们今天看到的 Facebook 跟 2004 年扎克伯格上线的版本完全不同。

过去 15 年间,Facebook 通过整合社交图谱、Newsfeed 和点赞机制三种功能,成功达到了全球化规模。这三种功能都不是 Facebook 首创。这家公司的成功之处在于越来越擅长这三种功能的配合,迎合用户、广告商和合规的需求。正是这种特点把 Facebook 和其他社区网站区别开来。彼时,FilePile , B3ta 和其他网站依然满足于相对隐秘的创新型社区。 而扎克伯格的野心及其投资者要求的是不断的增长和拓宽。2007 到 2009 年间,Facebook 用这三种 Web2.0 时代的产物,实现了快速扩张。

第一个元素「社交图谱」:与扎克伯格 同届的哈佛大学经济学学生 Philippe Bouzaglou 曾在 2002 年的学术论文中做出解释,社交图谱用来表现人群之间交织的复杂关系,这种类似于「 Kevin Bacon 六度分隔理论」的游戏,在 20 世纪 90 年代的互联网留言板非常流行。2000 年后的互联网社交媒体多少都应用了社交图谱的概念,从图片共享网站 Flickr 到稍纵即逝的SixDegrees.com。

在这些网站中,社交图谱通常用来帮助用户寻找好友或关注好友的动态。在社交媒体发展初期,用户能找到关联的人已经非常兴奋了。

在 2007 年 5 月的 Facebook 开发者大会上,扎克伯格发布了一项针对社交图谱的野心计划,他说道:「到目前为止,社交网络都是封闭的平台,而今天,我们将结束这一切。」相比于局限在一个网站的关系中,他把社交图谱看作一种在整个互联网联系人们的新方式。「社交图谱正在改变世界,我们正处于一个信息更容易获取,人们联系更加紧密的时代,是之前任何一个时代无法比拟的,而社交图谱就在中心点上」,扎克伯格如是说道。

2007 年 4 月,Facebook 的月度用户高达 2 千万,而当时全球互联网用户刚刚超过十亿。在这样的背景下,扎克伯格想要把每个人都联系起来的愿景显得野心勃勃,甚至太过于理想主义。当时还无法想象一个由 Facebook 联系起来的世界是什么样子,但在下一个十年,我们都看到了结果。

第二个元素 Newsfeed,从根本上改变了社交媒体的结构。像博客这种早期的社交网站,将用户视为内容创造者,所以都努力让用户发布内容变得更简单。用户只能通过访问博客页面或者RSS订阅来关注别人。

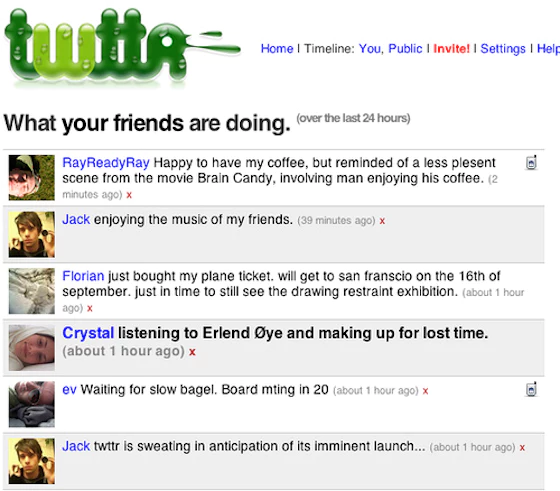

2006 年 Twitter 上线,让用户自己的内容跟好友的放在一起同时呈现。2006 年 7 月上线的版本里推出了时间线的概念,那时,发推只能通过短信,所以主页上依然以阅读好友的内容为主。

九月,Facebook 推出了自己的时间线—NewsFeed。通过与社交图谱的结合,Facebook 对 Newsfeed 的应用与以往的社交网站截然不同。这不再是一个用户能完全掌控的页面,而是专门为读者定制的无限信息流,与内容创造者不再有关系。

把用户从内容创造者变成内容消费者,这个变化是 Facebook 和 Twitter 增长的关键。这两个平台成了各种信息流的中心,你的好友、你关注的明星、你喜欢的品牌,可以实时发布文字,图片和视频。2007 年 iPhone 的发布更是让用户有了完美的信息浏览工具。仅仅几年时间,从 web 2.0 人人都是内容创造者,变成了人人都是举着一块屏幕滑动的内容消费者。

「点赞」是如何为 Facebook 赋能的

对 Facebook 而言,点赞的主要目的都是为了把用户行为转变为有效数据。

历史上,鼓掌并不是一个自发的行为,而是几个世纪间逐渐形成的文化产物;从罗马皇帝到情景喜剧,它是各种变相盈利和获得权力的工具。我们知道 Arthur C.Nielsen 用机械设备开创了广播评级,用电子表格分析听众,从而开启了大数据的先河。我们也知道音乐排行榜最初是为了便于在音乐杂志中售卖广告,但最终把唱片行业和战后流行文化推向了高潮。

「点赞」的故事集合了所有这些奇妙的点。跟鼓掌一样,「点赞」把我们对文化的复杂回应简化为一个动作。跟广播评级类似,点赞机制把看不见的用户行为变成可分析的数据。同时,跟音乐排行榜类似,「点赞」从我们对流行文化的狂热和回应中创造出了新的市场。

Facebook 2009 年 2 月 10 日上线了点赞功能,这在关注指标历史上是具有历史意义的一天。并不是 Facebook 发明了点赞功能,事实上此后 Facebook 便收购了一家几年前就开始使用点赞功能的网站 FriendFeed ;而是 Facebook 将点赞功能与社交图谱和 Newsfeed,这两个本身已经非常强大的功能进行了结合。

通过这种方式,Facebook 有条件从庞大的人群中获得难以想象的庞大的个人数据。2010 年 Facebook 又发布了图谱API,让开发者不仅能访问用户个人的活动,还可以访问其所有好友的活动。事实上,即使你不用 Facebook ,别人也可以通过你亲戚朋友的 Facebook 页面拼凑出你的信息。因此,如果开发者获得几千人的数据权限,就可以获得上百万人的数据。

虽然 Facebook 在 2014 年更新图谱 API 时对功能做了限制,但据 Digital Journalism Tow Center 研究负责人 Jonathan Albright的陈述,这次 Facebook 用更加强大的东西取代了它:

扎克伯格声称「把用户放第一位」,却在 2014 年 4 月发布了「个人验证信息」功能,把用户敏感的个人信息,包括朋友和家人的信息暴露给外界。

同一天,Facebook 还发布了最大的跟踪和精准广告投放系统「Audience Network」。同样地,这个系统更加扩大了Facebook 的数据库,并将广告投放到网站和互联网任何地方。

Jonathan Albright 图谱API: Facebook 的关键点与「剑桥分析」事件

扎克伯格关于连接世界的愿景刚刚提出两年,现在 Facebook 已经不仅仅是连接世界了,而是收集和分析数十亿人的情感,想法和信仰,并卖给想要的任何人。

对用户来说,Facebook 成了一个越来越定制化的观察世界的窗口。关于我们喜好的数据被用来绘制我们的社交图谱,用于改进算法,最终决定把什么呈现给我们。社交图谱和 NewsFeed 是 Facebook 增长的发动机,而点赞机制为其赋予了意义,并使其不仅做到了连接世界,更重构了人们看待世界的方式。

「点赞」是怎么被玩坏的

Facebook 过去几年的增长如此快速和复杂,难以概括。如今,快速增长带来的问题已经很明显了,而其未来的路却是难以预测。

我们可以责怪扎克伯格把 Facebook 的发展想得过于简单,但回过头来看,关注指标的发展是渐进式的,不是在某个盲目的时刻被创造出来,而是随着时间不断改变和适应的。与此相关的产业也不是一个人建立的,而是由内容生产者,广告商和投资者,甚至用户共同推动的。

如果我们要指出 Facebook 错在哪里,首先就是他们没有预料到,或者无法预料到将点赞机制加入社交图谱和 NewsFeed 的后果。

其次,Facebook 认为算法足以处理一个数十亿用户的平台。跟 Rob Manuel 只是想用一个点赞按钮减轻人工的工作量不同,Facebook 坚持认为只有不加人工干预的,纯粹的算法和技术干预才能使公司立足。

最后一点,Facebook 售卖数据给广告商的方式,打破了传统媒体市场的模式。过去,当新的媒体分包网络出现时,观众的分析和转化都会由市场上几家公司共同完成,没有任何一家公司可以控制市场。在电视产业,评级都由 Nielsen 或者 BARB 这种第三方独立公司完成。

我们可以从「点赞」中学到什么

如果我们要改变这种局面,不应该是从现在开始。事实上,Facebook 已经肆意利用我们的个人数据变现,夸大虚假新闻甚至影响美国大选的 2018 年。我们应该追溯到 2007 年,Facebook 仍是众多 web 2.0 时代创业公司中的一个。之后的两年,它完成了三种元素的结合,只是没人能想到这种结合会产生多么强大的力量。

我们可以把时间拨到那个时刻,像 20 世纪扳倒石油和电话垄断巨头一样,摧毁我们新兴的数字垄断巨头。我们可以对个人数据的使用提出规范化的条约,限制任何一个公司对我们喜好的利用和变现。也许我们还可以坚持没有任何一个平台可以出于成本或逻辑考虑,摒弃人工运营的干预。

但即使那样,我们也无法阻止下一个「点赞」功能的出现—也许会制造出一种新的垄断。改变世界的想法一开始都很渺小,就像 Rob Manuel 提出的,简单而具体的问题。而垄断就是由这些渺小的想法所组成的,难以预测更难以规范。

21 世纪最初的二十年间,我们已经可以窥见一些指数级技术对文化和社会带来的影响,这些技术的结合带来了难以想象的极速发展和复杂系统。单单关注某家公司和他们的运作,无法预测这些技术带来的变革和影响。

这些技术背后的想法来源于各种形态中的很多人,我们无法通过某个例子来规范。相反,我们应该看到这些指数级技术的共性,让技术开发者承担更多的社会责任。

比如早在 2007 年,我们就可以要求所有使用社交图谱, Newsfeed 和点赞机制的公司设立一个共同的标准。这一标准需要经过行业内部和政府的共同认可。这也许会使他们的发展放缓,但这也为我们了解和预测未来争取了时间。

伏尔泰和蜘蛛侠都曾说过「能力越大,责任越大」,问题是,有时强大的能力带来了极速的扩张,而承担责任却迟迟未见。

)